일단 문서의 모든 내용을 이해한 것이 아니라 찾아보고 공부할 것들이 많이 있다.

실제 하드웨어의 스펙도 실무에서 쓰는 것과 다른 부분이 많기 때문에

어떤 항목들에 대한 튜닝과 개선을 통해

넷플릭스 만큼은 아니더라도 대역폭을 더 적은 자원을 소모하면서

뽑아낼 것인가에 대한 연구는 해볼만할 것 같다.

FreeBSD의 기술행사인 EuroBSDCon 2022에서 발표된

넷플릭스의 프레젠테이션 자료는 아래와 같다.

공부해보자!

일단 문서의 모든 내용을 이해한 것이 아니라 찾아보고 공부할 것들이 많이 있다.

실제 하드웨어의 스펙도 실무에서 쓰는 것과 다른 부분이 많기 때문에

어떤 항목들에 대한 튜닝과 개선을 통해

넷플릭스 만큼은 아니더라도 대역폭을 더 적은 자원을 소모하면서

뽑아낼 것인가에 대한 연구는 해볼만할 것 같다.

FreeBSD의 기술행사인 EuroBSDCon 2022에서 발표된

넷플릭스의 프레젠테이션 자료는 아래와 같다.

공부해보자!

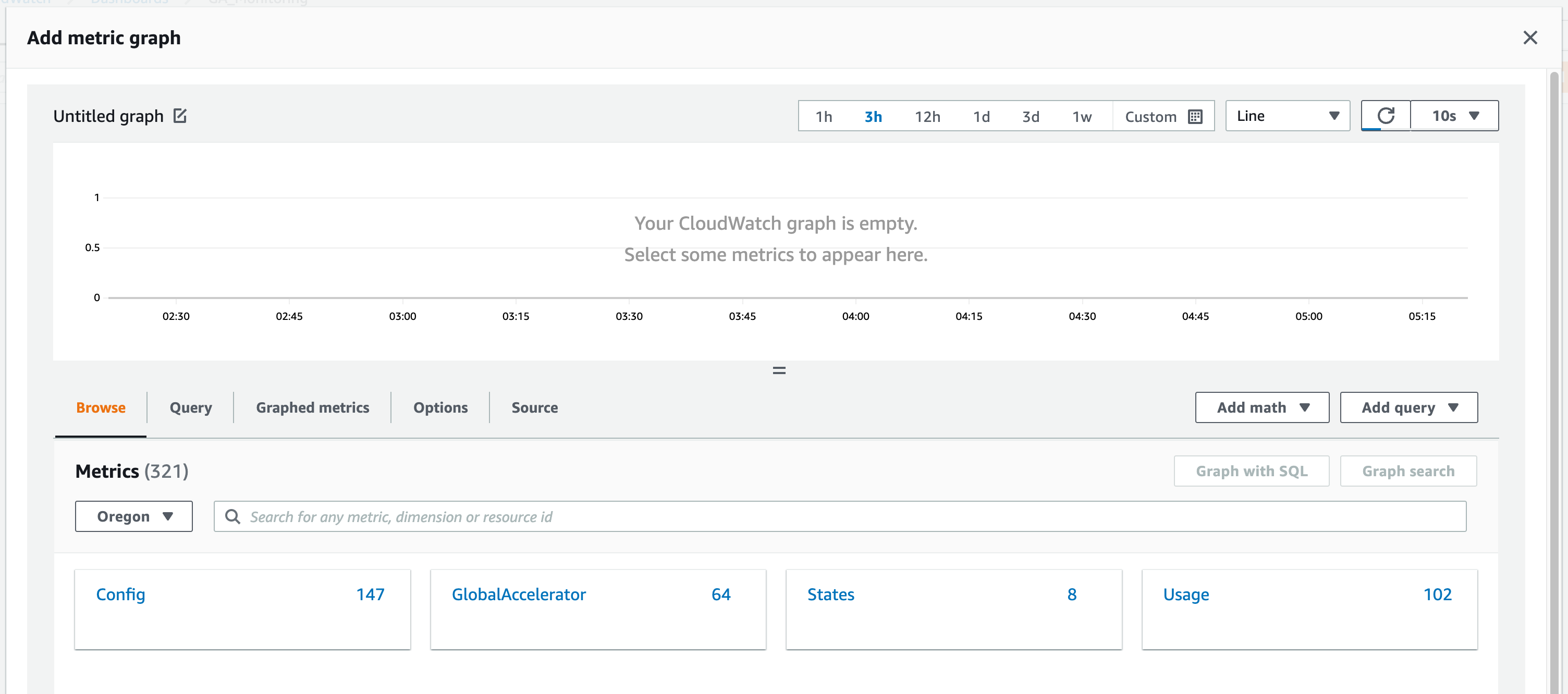

글로벌 Edge Location을 이용한 가속 상품 Global Accelerator

속칭 GA는 모니터링 할 수 있는 메트릭을 많이 제공하지는 않습니다.

Flowlog를 제공하긴 하지만 뭔가 서비스 레벨에서 모니터링하긴 애매하고...

가능한 지표들을 가지고 CloudWatch 대시보드로 구성해 보았습니다.

AWS의 제품들 중 일부는 특정 리전에서만 사용할 수 있거나

특정 리전에서만 모니터링 할 수 있는 제품들이 있습니다.

Global Accelerator 역시 그런 제품중 하나로

GA의 지표들은 US West 혹은 us-west-2로 표기되는 Oregon 리전에서 제공됩니다.

GlobalAccelerator 메트릭을 선택하면

하위에 여러가지 메트릭이 다시 나옵니다.

참 애매한 것이 중복되서 제공되는 메트릭들이 있어서

GlobalAccelerator, Listener, EndpointGroup 등이

뭉쳐서 나오는 것들이 있어서... 처음 보면 당황하기 딱 좋습니다.

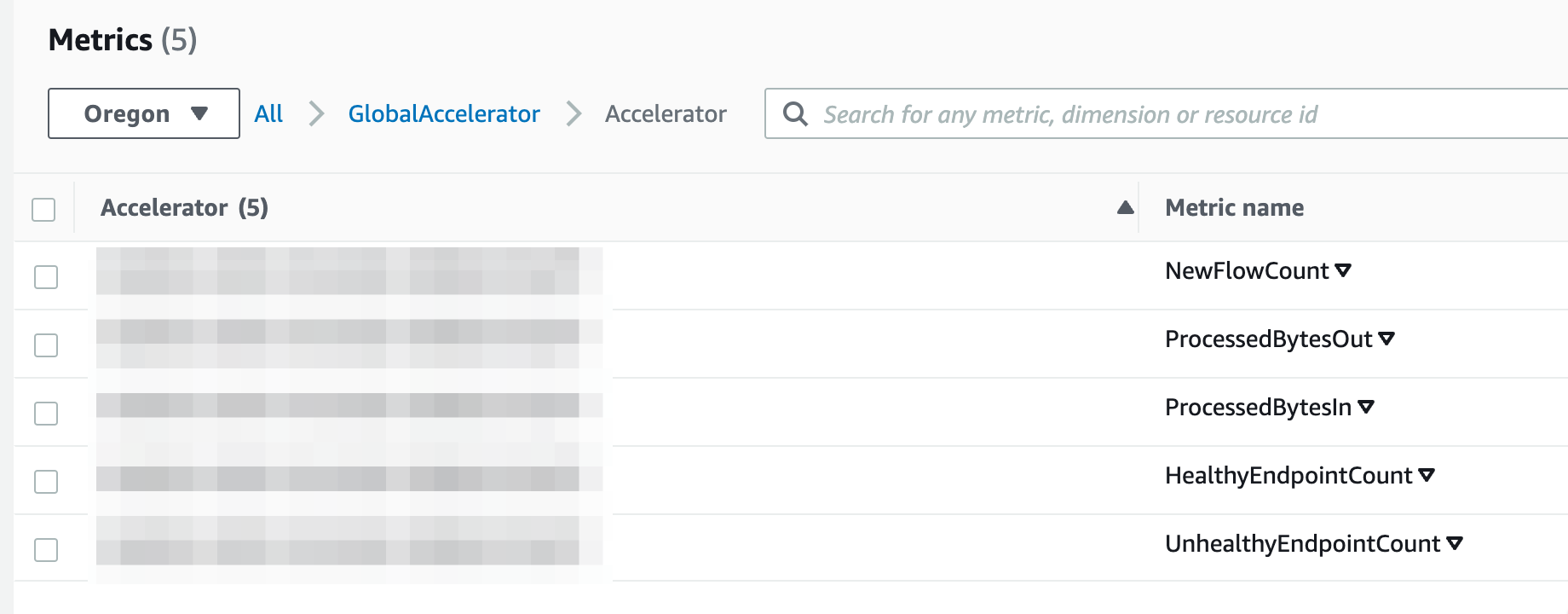

개인적으로 추천드리는 첫번째 지표는 Accelerator 입니다.

실제 GA 인스턴스?가 처리하는 지표 다섯가지가 이곳에 있습니다.

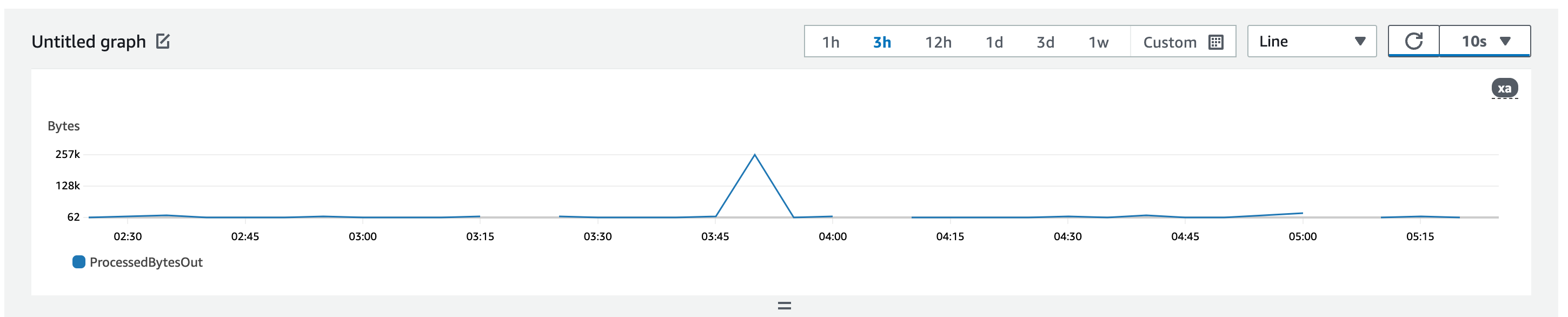

GA의 ProcessedBytesIn은 외부 혹은 업스트림으로부터 수신한 바이트

반대로 ProcessedBytesOut은 외부 혹은 업스트림으로 송신한 바이트입니다.

보통은 GA를 업스트림 가속으로 쓰기 때문에 In을 사용자가 업로드한 바이트

Out을 업스트림으로 내보낸 바이트로 생각하면 편리합니다.

다만 상황에 따라 이 메트릭이 별로일 수도 있습니다.

GA는 IPv4 only 일때 두개의 공인 IP, v4+v6 일때 4개의 IP를 제공하는데

이 메트릭으로는 합계 트래픽만 볼 수 있기 때문입니다.

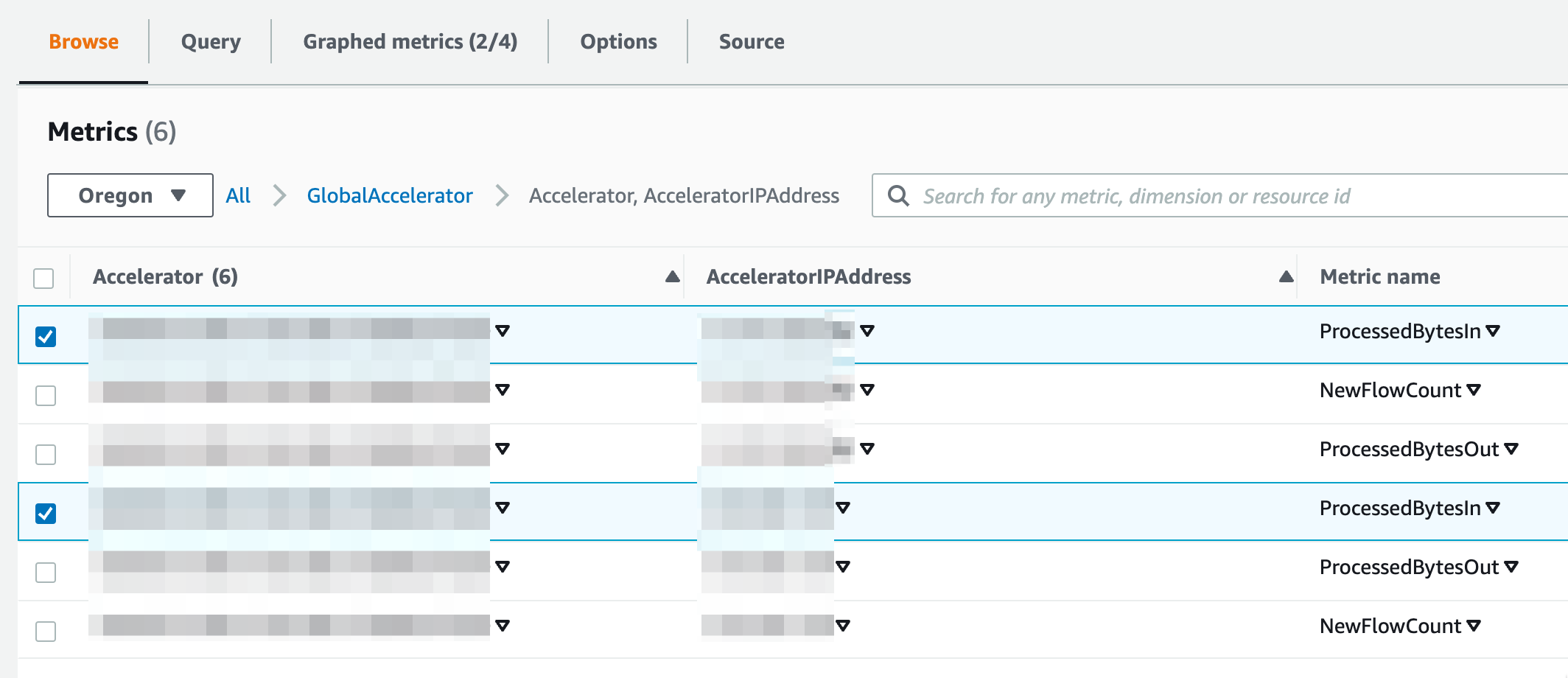

이때 활용하는 것이 AcceleratorIPAddress 지표입니다.

이 메트릭은 기본적으로 Accelerator의 메트릭중 ProcessedBytesIn/Out과 같습니다.

다만 차이점은 GA에 할당된 IP 단위로 보여준다는 점입니다.

즉, 특정한 IP에 문제가 생기는 경우에 대해 확인이 가능하다는 것을 의미합니다.

네, 요렇게 지표를 추가하면 GA VIP 별로 트래픽 흐름을 볼 수 있습니다.

다음 포스팅에서는 GA의 전송량대신 대역폭으로 보는 법을 살펴보겠습니다.

익숙한게 대역폭인데 AWS는 DataTransfer를 Bytes로 측정하다보니

CloudWatch 등의 메트릭도 동일한 기조로 되어 있어 다소 불편함이 있습니다 ㅎㅎ

요걸 CloudWatch Math로 풀어보겠습니다.

#aws #globalaccelerator #awsga #accelerator #가속 #아마존 #아마존웹서비스 #글로벌엑셀러레이터 #IT #cloud #publiccloud #cloudwatch

참 오래걸렸습니다.

처음 CKA 자격증을 취득해 보자고 생각했던 것이 작년 이맘때이니

정확히 1년되는 시점에 자격증을 취득했습니다.

이걸 정확히 기억하는 이유가, 시험 응시를 계획하던 시점에

리눅스 파운데이션에서 CKA 자격시험 50% 할인 쿠폰을 뿌리고 있었기 때문입니다 ㅎㅎ

50%는 잘 나오지 않는다고 알고 있어서 유효기간 1년임을 확인하고 바로 등록했던 것이죠.

25% 짜리 나왔다고 좋아서 글올렸던 흔적도 남아 있군요!

쿠버네티스 자격시험 CKA, CKAD, CKS 25% 할인쿠폰 - SCHOOL25

근래에 가장 각광받는 자격시험이 쿠버네티스 Kubenetes 관련된 자격증일 것 같습니다. 리눅스 파운데이션에서 주관하는 쿠버네티스 시험은 크게 3가지 종류인데요, 최근 모 조사기관에서 발표했

ondemand.tistory.com

여튼, 등록한 시험 유효기간 1년이 9월 8일에 종료되니

어서 시험을 신청하라는 메일을 받고 부랴부랴 재정비에 나섰습니다.

CKA 시험은 자격 시험 접수권(?)을 구매하면 1회의 시험을 볼 수 있습니다.

재미있는 것은 1회 시험에서 불합격하면 한번 더 시험을 보는 기회를 줍니다.

단, 1회 시험을 접수해 놓고 No show로 탈락한 경우 re-take 기회가 주어지지 않습니다.

사실 저도 그랬습니다.

시험을 등록해 두고 날짜를 까먹고 있다가 하루 지난후에 시험을 못친 것을 확인했습니다.

이 비싼 시험을 놓치다니... 하고 한탄만 하기에는 비용이 너무 비쌌습니다.

지금은 환율이 1400원/달러가 넘어가고 있으니 더 비싸졌죠?

어떻게 구제 받을 수 없을지 폭풍 검색을 해봤지만 답은 없었습니다.

하지만 포기할 제가 아니었죠.

Linux Foundation 트레이닝 센터에 로그인 한 후 Support 티켓을 열고

시차 계산을 잘못해서 놓쳤다... re-take 할 수 있게 어떻게 안되겠냐 사정을 했습니다.

몇 번의 이메일을 주고 받고 최종적으로 받은 답은 바로 재시험 기회 부활!

두드리면 얻을 것이다라는 격언을 몸소 느낄 수 있는 시간이었습니다!

혹시 저처럼 시험 스케쥴링 해두고 No show로 탈락하신 분들은

re-take 기회 부활에 대해 문의를 꼭 해보시기 바랍니다!

375달러 1400원 환율은 정말 큰 돈입니다 ㅠㅠ

요즘 많은 자격시험이 그러하듯, CKA도 실무형 시험입니다.

시험 자체가 단답식이 아니라 가상 k8s 환경에서 문제를 찾고 해결하는 것이 대부분입니다.

그러다보니 실무에서 k8s를 빡세게 쓰지 않는 분들이 다소 불리합니다.

그런 상황 때문인지 많은 CKA 자격증 강의 및 강사들은

udemy 등을 통해 강의를 수강하는 사람들을 대상으로

자신이 운영하는 트레이닝 서비스에서 k8s 랩을 해볼 수 있도록 해주고 있습니다.

시험 범위가 꽤나 넓기 때문에 udemy 등에서 강의를 한번 들어보는 것을 추천드리고

시험이 임박해오면 각 강의에서 제공하는 Mock Exam과

랩 과제 중심으로 반복 연습하면서 부족한 지식들을 채우고 까먹은 것을 다시 공부하는게 효과적입니다.

추천 드리는 udemy 강의는 다음과 같습니다.

Certified Kubernetes Administrator (CKA) Practice Exam Tests

Prepare for the Certified Kubernetes Administrators Certification with live practice tests right in your browser - CKA

www.udemy.com

시험은 크게 세가지 배점으로 나뉘어 집니다.

13점짜리 가장 배점 높은 문제와 중간 난이도의 7점 짜리 문제들.

그리고 다소 쉬운 4점짜리 문제들로 구성되어 있습니다.

4점짜리 문제들은 설정되어 있는 쿠버네티스 클러스터의 정보를 확인하는 것이 주류입니다.

확인된 정보를 특정 경로에 파일로 떨어뜨려 제출하거나

클러스터 구현에서 빠진 간단한 설정을 업데이트 하는 것이 주류입니다.

즉, 기본적인 k8s 지식을 바탕으로 kubectl 명령으로 비교적 쉽게 풀어낼 수 있습니다.

7점짜리 문제들은 조금 난이도가 있습니다.

구현 되어 있는 클러스터의 중간 난이도 문제점들을 확인하고

문제점을 해결하는 과제들이 주어지게 됩니다.

4점짜리에 비해 다소 어렵지만 차근히 풀면 못풀 문제도 아니긴 합니다.

k8s의 다양한 리소스 개념을 잘 인식하고 있어야 당황하지 않고 풀 수 있습니다.

제 경우 13점짜리 문제는 문제가 발생한 클러스터를 복구하는 문제였습니다.

쿠버네티스 뿐만 아니라 간단한 리눅스 시스템에 대한 이해가 필요했고

k8s와 리눅스 전반에 걸쳐 문제점을 찾아나가는 접근을 해야 했습니다.

정확히 1분 남기고 이 문제를 풀었던 것이 합격의 최종 관문이었습니다 ^^;;

리모트로 시험을 보면서 온라인으로 진행되는 만큼 당황할만한 요소가 꽤 있습니다.

시험 시작 시간 30분 전에 미리 접속해서 필요한 클라이언트 다운로드 등을 진행하는게 좋습니다.

막상 다운로드가 느리거나 잘 안되면 마음이 또 조급해 지기도 합니다 ㅜㅜ

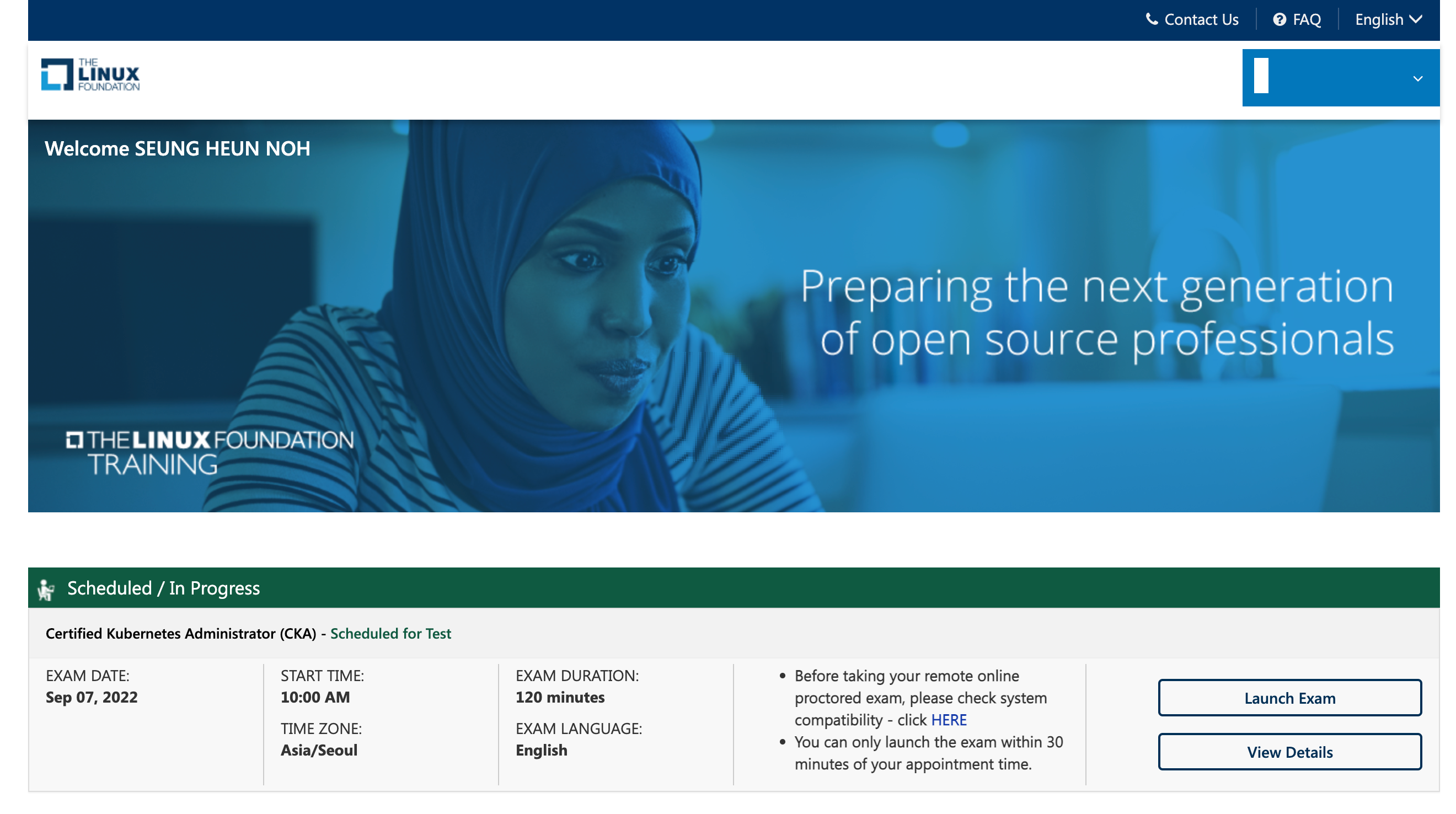

시험은 리눅스 파운데이션의 트레이닝 포털을 통해 진입합니다.

Scheduled/In Progress에 시험 안내가 나오고 있지요?

사전에 `click HERE` 등의 링크를 눌러서 환경 점검을 하시고

마음의 준비가 끝나면 `Launch Exam`을 눌러 시험에 환경으로 진입합니다.

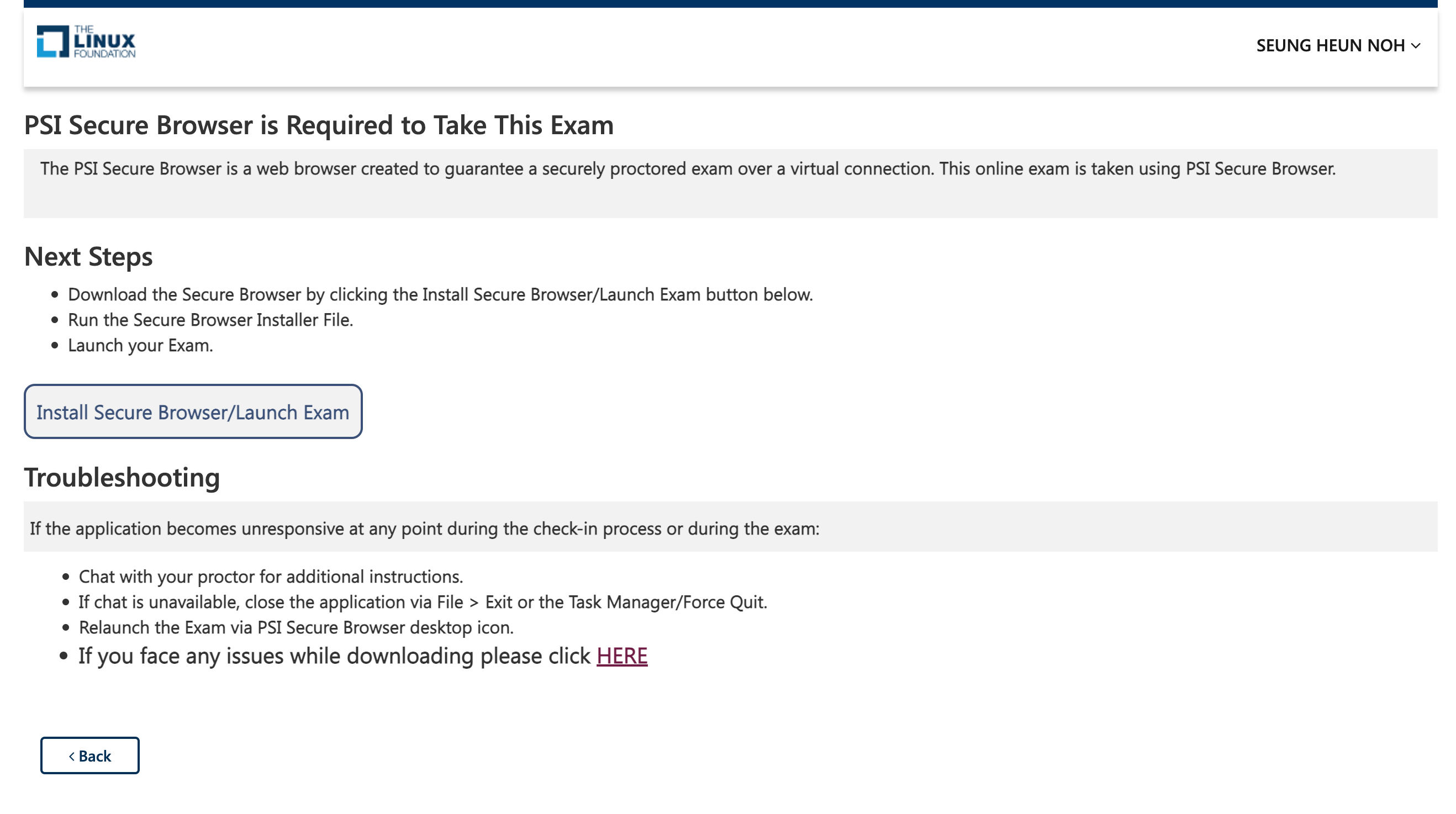

2022년 6월부터 시험 환경이 변경되었습니다.

기존에는 (저는 쳐보지 못했습니다만) 자신의 로컬 브라우저를 이용했고

시험 환경에도 터미널로 접근했던 것 같기도 한데... 자세히는 모르겠구요 ㅎㅎ

변경된 시험환경은 브라우저 내에 가상 리눅스 GUI 환경이 제공되고

가상 리눅스 GUI 환경에서 브라우저, 터미널 등을 사용한다고 보시면 됩니다.

네, 더럽게 느립니다 ㅜㅜ

그리고 습관적으로 cmd-tab 을 누르는데 자꾸 로컬 환경에서 동작하는 바람에 여러가지로 당황할 수 밖에 없었습니다.

보안 브라우저를 설치하고 시험 시작을 누르면 보안 브라우저가 실행중인 앱을 모두 종료 시킵니다.

그런데 제 경우 제대로 죽지 않은 프로그램이 있어서 cmd-tab 누를때마다 자꾸 그 화면이...

심지어 한글로 된 내용이 떠있는 상태라 부정 행위로 떨어지나... 걱정했었습니다.

고로.. 시험 시작전에 로컬 앱은 일단 다 죽여주시기 바랍니다!

PSI 시큐어 브라우저의 화면구성은 크게 2단으로 되어 있습니다.

화면 좌측으로 문제가 나오는 영역이 있고, 우측이 가상 리눅스 GUI 환경입니다.

시험이 시작되면 GUI 환경에서 터미널을 직접 실행해야 합니다.

1.

친절하게도 문제 영역에는 문제와 관련된 k8s 공식 문서 링크를 제공해 줍니다.

CKA 예전 시험에는 이렇게 제공되지 않았던 것 같은데 (물론 안쳐봐서 정확한 건 아닙니다 ㅎㅎ)

k8s 공식 문서를 탐색하는 스킬을 굳이 연습하지 않으셔도 큰 지장 없다고 생각하시면 됩니다.

그저 문제 위에 나열된 2~3가지 링크를 빠르게 활용하는 것이 문제를 푸는 지름길입니다!

2.

가상 환경 속의 터미널에 뭔가 붙여 넣기 해야 할일이 무척 많은데

키보드 숏컷이 약간 차이가 있으니 주의해야 합니다.

가상 환경이 시작되면서 해당 부분에 대한 안내가 나오긴 합니다만

습관이 무섭다고... 단축키를 이용하면서 계속 실수를 연발했습니다.

문제 후반부부터는 그냥 마우스로 클릭~ 클릭~ 하면서 복사했네요

3.

배점이 낮은 문제를 먼저 푸는게 좋습니다.

저는 가장 처음에 13점짜리 문제가 나와서... 한참 헤메다 보니 시간이 와르르...

중간에 멘탈을 붙잡아서 다행이었습니다만 정말 당황했었습니다.

시험 문제는 앞뒤로 왔다갔다 할 수 있고 까리한건 플래그 걸어두고 다시 확인할 수 있습니다!

4.

시험 시작전에 시험 보는 환경에 대해서 꼼꼼하게 검사를 합니다.

저는 1인 미팅실을 빌려서 들어가서 이용했는데요, 노트북을 들고 내장 카메라로 구석구석을 보여달라고 합니다.

채팅으로 영문으로 지시사항을 내려주기 때문에 잘 보고 하라는 것을 잘 하면 됩니다.

시험 보자마자 팁을 정리하려고 했는데 많이 늦어졌네요.

시험 문제도 많이 기억이 났었는데... 늙어서 그런지 몇 일 사이에 기억에 남는게 하나도 없습니다 ㅜㅜ

여튼, 흥미롭게 볼 수 있는 시험이었고 공부도 정말 많이 할 수 있는 시간이었습니다.

이제 어디가서 k8s 관련해서 명함 살짝~ 내밀 수 있는 수준이 된 것 같아

회의 시간에도 당당하게 어깨를 펼 수 있게 된 것이 가장 큰 수확입니다 ㅎㅎ

CKA를 준비하는 모든 분들의 앞날에 합격의 영광이 가득하길 기원합니다!

udemy 가 제공하는 CKA 강의중 한글 자막이 있는 것은 아직 못본 것 같은데요

한글 자막이 필요하다면 전체 CKA 주제 강의 목록 살펴보시면서 찾아보시는 것도 좋겠습니다.

온라인 강의 - 자신의 일정에 맞춰 뭐든지 배워 보세요 | Udemy

Udemy는 204,000개 이상의 강의와 5천 4백만명 이상의 수강생이 있는 온라인 학습 및 교수 마켓플레이스입니다. 프로그래밍, 마케팅, 데이터 과학 및 그 밖의 분야에 대해 배워 보세요.

www.udemy.com

마지막으로... 자랑하고 마칩니다.

CKA: Certified Kubernetes Administrator was issued by The Linux Foundation to SEUNG HEUN, NOH.

Earners of this designation demonstrated the skills, knowledge and competencies to perform the responsibilities of a Kubernetes Administrator. Earners demonstrated proficiency in Application Lifecycle Management, Installation, Configuration & Validation, C

www.credly.com

본 블로그의 많은 글들은 제휴 마케팅을 통해 소정의 수수료를 지급받을 수 있습니다.

엊그제 CKA (Certified Kubenetes Administrator) 자격을 취득했습니다.

AWS Solutinos Architect Associate 취득이 거의 3년전이었으니

3년만에 또 하나의 자격증을 추가하는 <게으름>을 선보였습니다 ㅎㅎ

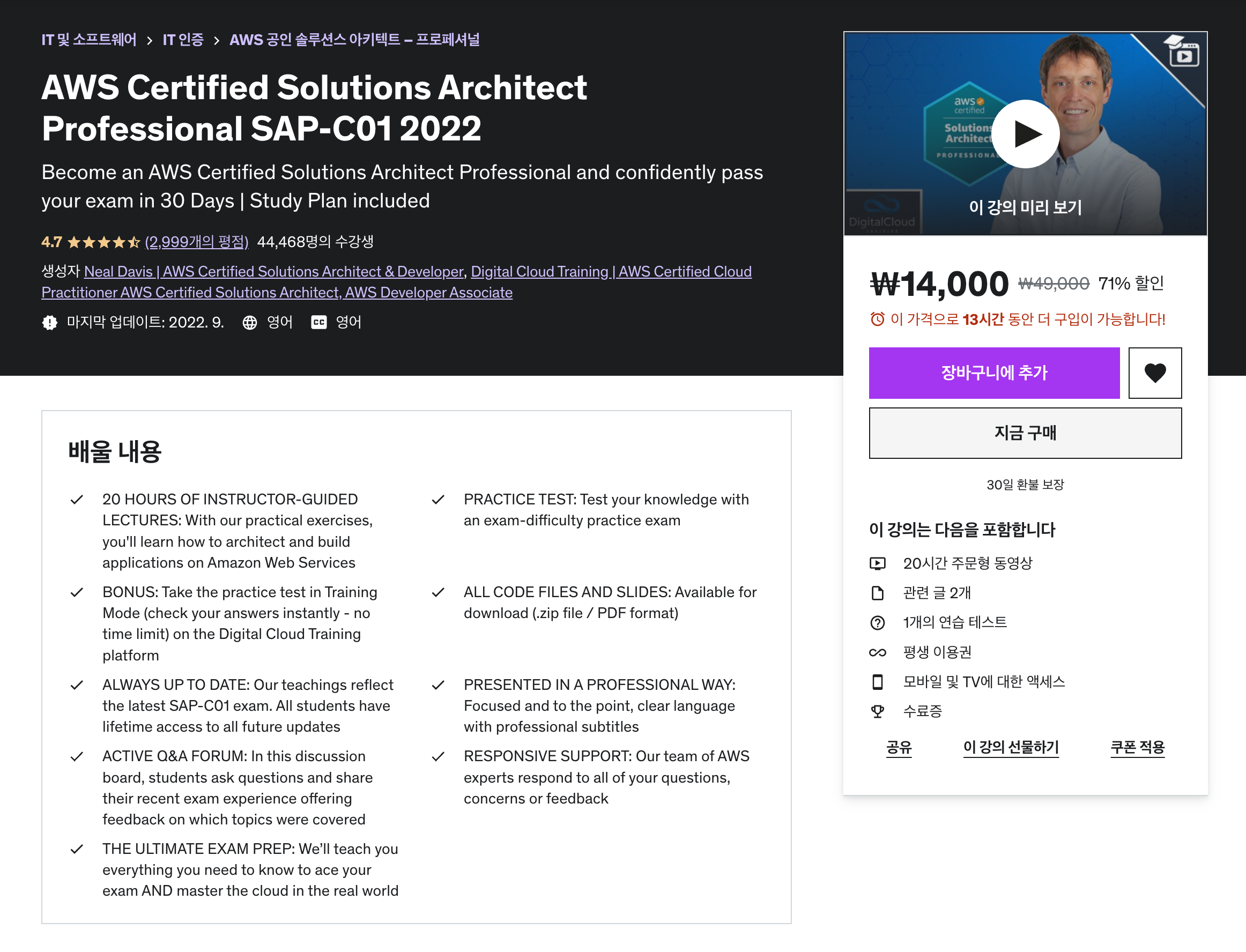

CKA 취득후 좀 쉴까 했더니, AWS SAA 자격이 11월 만료라고 갱신하라는 알람이 똬악...

그래서 부랴부랴 유데미 Udemy 에서 강의를 검색해 봤습니다.

SAA 취득할때는 Ryan 님의 강의로 도움을 많이 받았는데,

Ryan님의 회사 Cloud Guru가 다른 회사에 인수되면서 강의가 다 내려갔습니다 ㅜㅜ

고심끝에 고른 강의는 Neal Davis님의 SAP 강의

일단 20시간 VOD라 짧고 굵게 공부할 수 있을 것 같고

본인이 운영하는 Digital Cloud Training 이라는 서비스에서

실습할 수 있는 환경을 제공해 주는 것 같아 과감히 선택했습니다.

가격도 정가 49000원 대비 추석 맞이 할인 71% 적용중이라

14000원으로 아주아주 착해서... 과감히 결제했습니다 ㅋ

이제 11월까지 한번 또 달려봐야겠습니다!

그나저나 이거 공부하면 또... 번역 작업은 언제하나 싶은 생각이 듭니다.

아직 챕터 1도 안끝났는데... 역시 잠을 줄여야 합니다 ㅜㅜ

강의를 자세히 살펴보려면 아래 링크로~ 샘플 강의 몇 가지를 들어볼 수 있습니다.

AWS Certified Solutions Architect Professional SAP-C01 2022

Become an AWS Certified Solutions Architect Professional and confidently pass your exam in 30 Days | Study Plan included

www.udemy.com

본 포스팅은 제휴마케팅을 통해

소정의 수수료를 지급받을 수 있습니다.

쿠버네티스 클러스터의 네트워크 구성에 문제가 생기면

다음과 같은 에러를 만날 수 있습니다.

root@controlplane:/# k get all -n triton

NAME READY STATUS RESTARTS AGE

pod/mysql 0/1 ContainerCreating 0 67s

pod/webapp-mysql-54db464f4f-5jtq2 0/1 ContainerCreating 0 67s

...

...

root@controlplane:/# k describe pod/webapp-mysql-54db464f4f-5jtq2

Events:

Type Reason Age From Message

---- ------ ---- ---- -------

Normal Scheduled 14m default-scheduler Successfully assigned triton/webapp-mysql-54db464f4f-648sr to controlplane

Warning FailedCreatePodSandBox 14m kubelet Failed to create pod sandbox: rpc error: code = Unknown desc = [failed to set up sandbox container "7fba1fad2f3e8297e080cfd1ab1d75615f1d036acf0eb6182514dcebbf2cf089" network for pod "webapp-mysql-54db464f4f-648sr": networkPlugin cni failed to set up pod "webapp-mysql-54db464f4f-648sr_triton" network: unable to allocate IP address: Post "http://127.0.0.1:6784/ip/7fba1fad2f3e8297e080cfd1ab1d75615f1d036acf0eb6182514dcebbf2cf089": dial tcp 127.0.0.1:6784: connect: connection refused, failed to clean up sandbox container "7fba1fad2f3e8297e080cfd1ab1d75615f1d036acf0eb6182514dcebbf2cf089" network for pod "webapp-mysql-54db464f4f-648sr": networkPlugin cni failed to teardown pod "webapp-mysql-54db464f4f-648sr_triton" network: Delete "http://127.0.0.1:6784/ip/7fba1fad2f3e8297e080cfd1ab1d75615f1d036acf0eb6182514dcebbf2cf089": dial tcp 127.0.0.1:6784: connect: connection refused]

Normal SandboxChanged 4m (x47 over 14m) kubelet Pod sandbox changed, it will be killed and re-created.

에러 메세지를 보면 CNI 문제인 것처럼 보입니다.

이때 클러스터가 사용중인 CNI 를 확인할 필요가 있겠죠?

/opt/cni/bin 경로에서 클러스터에 설치된 CNI 플러그인을 확인할 수 있습니다.

root@controlplane:/# ls /opt/cni/bin/ -al

total 81676

drwxrwxr-x 2 root root 4096 Sep 4 00:52 .

drwxr-xr-x 3 root root 4096 Aug 25 2021 ..

-rwxr-xr-x 1 root root 4159518 May 13 2020 bandwidth

-rwxr-xr-x 1 root root 4671647 May 13 2020 bridge

-rwxr-xr-x 1 root root 12124326 May 13 2020 dhcp

-rwxr-xr-x 1 root root 5945760 May 13 2020 firewall

-rwxr-xr-x 1 root root 3069556 May 13 2020 flannel

-rwxr-xr-x 1 root root 4174394 May 13 2020 host-device

-rwxr-xr-x 1 root root 3614480 May 13 2020 host-local

-rwxr-xr-x 1 root root 4314598 May 13 2020 ipvlan

-rwxr-xr-x 1 root root 3209463 May 13 2020 loopback

-rwxr-xr-x 1 root root 4389622 May 13 2020 macvlan

-rwxr-xr-x 1 root root 3939867 May 13 2020 portmap

-rwxr-xr-x 1 root root 4590277 May 13 2020 ptp

-rwxr-xr-x 1 root root 3392826 May 13 2020 sbr

-rwxr-xr-x 1 root root 2885430 May 13 2020 static

-rwxr-xr-x 1 root root 3356587 May 13 2020 tuning

-rwxr-xr-x 1 root root 4314446 May 13 2020 vlan

lrwxrwxrwx 1 root root 18 Sep 4 00:52 weave-ipam -> weave-plugin-2.8.1

lrwxrwxrwx 1 root root 18 Sep 4 00:52 weave-net -> weave-plugin-2.8.1

-rwxr-xr-x 1 root root 11437320 Sep 4 00:52 weave-plugin-2.8.1

그러면 사용중인 CNI 플러그인의 설정은 어디 있을까요?

바로 /etc/cni/net.d/ 경로에 있습니다.

weave 설정 파일만 존재하고 /opt/cni/bin 경로의 내용을 미루어 봤을 때

이 클러스터는 CNI로 weave를 쓰도록 구성되어 있다는 추론이 가능합니다.

root@controlplane:/# ls -al /etc/cni/net.d/

total 12

drwxr-xr-x 2 root root 4096 Sep 4 00:52 .

drwxr-xr-x 3 root root 4096 Sep 4 00:52 ..

-rw-r--r-- 1 root root 318 Sep 4 00:52 10-weave.conflist

그렇다면 왜 에러가 발생했고 어플리케이션 pod 가 구동되지 않은 것일까요?

weave는 CNI 플러그인이고 설치 및 동작되고 있는 경우

weave pod이 kube-system 네임스페이스에서 확인되어야 합니다.

root@controlplane:/# k get all -n kube-system

NAME READY STATUS RESTARTS AGE

pod/coredns-74ff55c5b-s8jgh 1/1 Running 0 33m

pod/coredns-74ff55c5b-vnsv7 1/1 Running 0 33m

pod/etcd-controlplane 1/1 Running 0 34m

pod/kube-apiserver-controlplane 1/1 Running 0 34m

pod/kube-controller-manager-controlplane 1/1 Running 0 34m

pod/kube-proxy-6jssm 1/1 Running 0 33m

pod/kube-scheduler-controlplane 1/1 Running 0 34m어라?

그런데 시험 환경에는 weave 관련된 이름이 보이지 않습니다.

weave.works 웹 사이트에서 아래 경로를 방문하여

커스텀 k8s용 설치 manifest 파일을 확인해 봅시다.

https://www.weave.works/docs/net/latest/kubernetes/kube-addon/

Integrating Kubernetes via the Addon

The following topics are discussed: Installation Before installing Weave Net, you should make sure the following ports are not blocked by your firewall: TCP 6783 and UDP 6783/6784. For more details, see the FAQ. Weave Net can be installed onto your CNI-ena

www.weave.works

$ kubectl apply -f "https://cloud.weave.works/k8s/net?k8s-version=$(kubectl version | base64 | tr -d '\n')"

위 명령을 수행하여 weave CNI 플러그인을 설치합시다.

이제 weave plugin이 설치되었으니 pod가 구동되는지 확인해 보겠습니다.

root@controlplane:/# k get all -n kube-system

NAME READY STATUS RESTARTS AGE

pod/coredns-74ff55c5b-s8jgh 1/1 Running 0 40m

pod/coredns-74ff55c5b-vnsv7 1/1 Running 0 40m

pod/etcd-controlplane 1/1 Running 0 40m

pod/kube-apiserver-controlplane 1/1 Running 0 40m

pod/kube-controller-manager-controlplane 1/1 Running 0 40m

pod/kube-proxy-6jssm 1/1 Running 0 40m

pod/kube-scheduler-controlplane 1/1 Running 0 40m

pod/weave-net-9kbqw 2/2 Running 0 43s아까 보이지 않던 pod/weave-net-xxxxx가 보입니다.

이제 서비스 클러스터의 pod 상태를 보겠습니다.

root@controlplane:/# k get all -n triton

NAME READY STATUS RESTARTS AGE

pod/mysql 1/1 Running 0 12m

pod/webapp-mysql-54db464f4f-5jtq2 1/1 Running 0 12mpod의 상태가 Running으로 바뀌었습니다.

describe로 상태를 보면 특별히 CNI 이슈가 해소된 것에 대한 메세지는 남지 않는 것 같습니다.

다만 pod가 잘 동작하는 것으로 이슈가 해소된 것을 알 수 있겠네요!

k8s 관리자라면 꼭 공부해야 하는 CKA는 아래 강의를 추천드립니다.

강사가 제공하는 별도 Lab 환경이 정말 진국인 강의입니다!

Certified Kubernetes Administrator (CKA) Practice Exam Tests

Prepare for the Certified Kubernetes Administrators Certification with live practice tests right in your browser - CKA

www.udemy.com

조금더 개발자에게 필요한 내용을 담은 CKAD를 준비한다면 역시 아래 강의가 좋겠습니다!

Kubernetes Certified Application Developer (CKAD) Training

Learn concepts and practice for the Kubernetes Certification with hands-on labs right in your browser - DevOps - CKAD

www.udemy.com

본 포스팅은 제휴마케팅을 통해 소정의 수수료를 지급 받을 수 있습니다.

성능 측정은 인프라의 기본입니다.

특히 서버와 네트워크의 성능 측정은 현업에서 자주 요구되는 시험 중 하나입니다.

다양한 방법의 시험이 있겠지만, 리눅스 환경에서는 iperf라는 걸출한 도구가 있어 시험이 쉽습니다.

물론 실제 어플리케이션의 성능 측정 등은 nGrinder와 같은 부하 도구를 사용해야 합니다.

iperf의 가장 최신 버전은 3 입니다.

각 리눅스 환경에서 패키지 매니저를 이용하여 쉽게 설치 가능합니다.

제 경우는 CentOS 환경이라 yum 으로 설치를 진행했습니다.

$ sudo yum install iperf3

...

...

Dependencies Resolved

======================================================================================================================

Package Arch Version Repository Size

======================================================================================================================

Installing:

iperf3 x86_64 3.1.7-2.el7 base 79 k

Transaction Summary

======================================================================================================================

Install 1 Package

Total download size: 79 k

...

...

Running transaction

Installing : iperf3-3.1.7-2.el7.x86_64 1/1

Verifying : iperf3-3.1.7-2.el7.x86_64 1/1

Installed:

iperf3.x86_64 0:3.1.7-2.el7

iperf3는 서버 역할을 할 데몬과 클라이언트 역할을 할 데몬을 실행함으로써 시험을 수행하게 됩니다.

성능 측정을 하고자 하는 대상 장비, 인스턴스에서 iperf3를 서버 모드로 실행하고

다른 장비에서 iperf3를 클라이언트 모드로 실행하여 성능을 측정합니다.

iperf3를 서버 모드로 실행하기 위해서는 -s 파라메터를 지정합니다.

서버의 성능은 대역폭 혹은 전송량으로 표기되는데

-f 파라메터 뒤에 소문자 m, g, t 등을 사용하면 대역폭으로

-f 파라메터 뒤에 대문자 M, G, T 등을 사용하면 전송량으로 표기합니다.

iperf2는 기본적으로 5201 포트로 수신을 합니다만

다른 포트를 사용하기 위해 -p 파라메터와 포트 번호를 지정할 수도 있습니다.

// 서버 모드로 iperf3를 실행

$ iperf3 -s

// 서버 모드로 iperf3를 실행하되 대역폭을 Mbps로 표기

$ iperf3 -s -f m

// 서버 모드로 iperf3를 실행하되 대역폭을 Gbps로 표기

$ iperf3 -s -f g

// 서버 모드로 iperf3를 실행하되 전송량 GB/sec로 표기

$ iperf3 -s -f G

// 기본 포트(5201)가 아닌 지정된 포트로 서버 구동

$ iperf3 -s -f g -p 1234

-----------------------------------------------------------

Server listening on 1234

-----------------------------------------------------------

서버를 구동했다면 이제 클라이언트를 구동할 차례입니다.

옵션은 서버로 쓸때와 비슷한데요

접속 대상 iperf3 서버 IP를 -c 옵션으로 지정한다는 정도의 차이가 있습니다.

// 서버 10.20.30.40 으로 시험 패킷을 전송

$ iperf3 -c 10.20.30.40

// 서버 10.20.30.40를 1234번 포트로 연결하여 시험 패킷을 전송

$ iperf3 -c 10.20.30.40 -p 1234

// 시험 패킷을 전송하되 단위를 Mbps로 표기

$ iperf3 -c 10.20.30.40 -p 1234 -f m

// 시험 패킷을 전송하되 단위를 MB/sec로 표기

$ iperf3 -c 10.20.30.40 -p 1234 -f M

기본적으로 iperf3는 TCP 시험을 수행합니다.

그런데 UDP 도 널리 쓰이고 있기 때문에 시험이 필요할 수 있습니다.

이때는 다음과 같이 -u 옵션을 사용하면 됩니다.

서버는 -u 옵션을 사용하지 않아도 되고, 클라이언트에서만 -u 옵션을 사용하면 됩니다.

$ iperf3 -c 10.20.30.40 -p 1234 -f M -u

Connecting to host 10.20.30.40, port 1234

[ 4] local 10.20.30.50 port 32888 connected to 10.20.30.40 port 1234

[ ID] Interval Transfer Bandwidth Total Datagrams

[ 4] 0.00-1.00 sec 116 KBytes 0.11 MBytes/sec 82

[ 4] 1.00-2.00 sec 129 KBytes 0.13 MBytes/sec 91

[ 4] 2.00-3.00 sec 127 KBytes 0.12 MBytes/sec 90

[ 4] 3.00-4.00 sec 129 KBytes 0.13 MBytes/sec 91

[ 4] 4.00-5.00 sec 127 KBytes 0.12 MBytes/sec 90

[ 4] 5.00-6.00 sec 129 KBytes 0.13 MBytes/sec 91

[ 4] 6.00-7.00 sec 127 KBytes 0.12 MBytes/sec 90

[ 4] 7.00-8.00 sec 129 KBytes 0.13 MBytes/sec 91

[ 4] 8.00-9.00 sec 127 KBytes 0.12 MBytes/sec 90

[ 4] 9.00-10.00 sec 129 KBytes 0.13 MBytes/sec 91

- - - - - - - - - - - - - - - - - - - - - - - - -

[ ID] Interval Transfer Bandwidth Jitter Lost/Total Datagrams

[ 4] 0.00-10.00 sec 1.24 MBytes 0.12 MBytes/sec 0.006 ms 0/897 (0%)

[ 4] Sent 897 datagrams

iperf Done.

현실의 서버들은 단일 TCP 연결이 아니라 다중 TCP 연결을 쓰게 됩니다.

iperf3는 이런 상황을 대비하여 다중 스트림을 쏠 수 있는 기능도 제공합니다.

-t 옵션을 사용하면서 뒤에 스트림 숫자를 지정해 주면 됩니다.

$ iperf3 -c 10.20.30.40 -p 1234 -f m -P 20

소개한 옵션들은 사실 기본적인 옵션들입니다.

각자의 상황에 필요한 옵션은 공식 문서를 통해 찾아 보는게 좋겠습니다!

https://github.com/esnet/iperf

GitHub - esnet/iperf: iperf3: A TCP, UDP, and SCTP network bandwidth measurement tool

iperf3: A TCP, UDP, and SCTP network bandwidth measurement tool - GitHub - esnet/iperf: iperf3: A TCP, UDP, and SCTP network bandwidth measurement tool

github.com

앞선 글에서 계속 이어집니다.

별 내용은 없습니다만, 앞의 글은 아래 링크로 보실 수 있습니다.

SRE와 DevOps의 차이는 무엇일까? #1 (부제 - SRE는 무엇을 해야 하는가)

구글이 NEXT 2018의 IO116 세션으로 발표했던 Improving Reliability with Error Budgets, Metrics and Tracing in Stackdriver를 읽으면서 일부 내용을 요약해 봤습니다. 내용을 읽으면서 한번 요약을 해보고 이..

ondemand.tistory.com

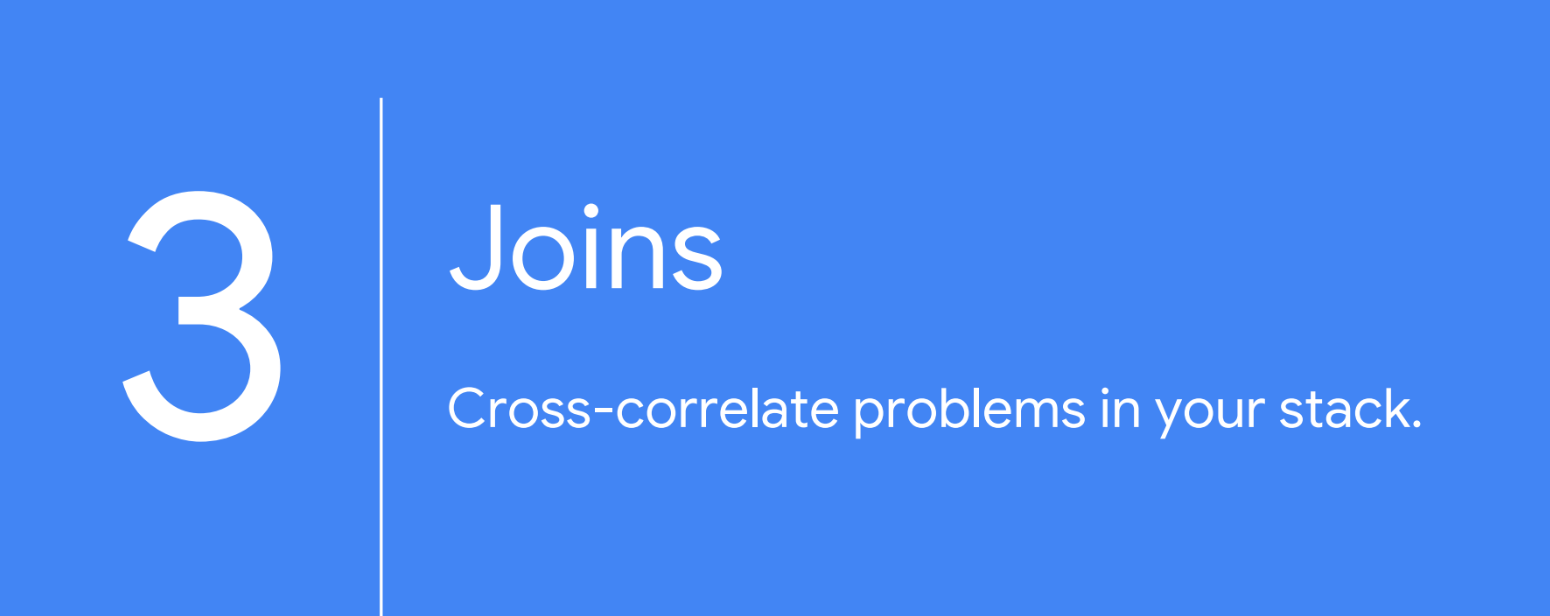

Stackdriver를 비롯하여 사용가능한 도구가 다르기 때문에... 장표 막 넘기고 4컷으로 요약

일단 알러팅이 정확해야 지치지 않는다

하나씩 레이어를 치우면서 원인을 찾아보자

서로 다른 도메인의 데이터를 관계시켜 원인을 찾아보자

추적 데이터, 높은 빈도로 출현하는 데이터의 조합?

이를 바탕으로 가설을 세우고 시험해 보는 것은 빠른 원인 판단에 도움이 됨

구글이 NEXT 2018의 IO116 세션으로 발표했던

Improving Reliability with Error Budgets, Metrics and Tracing in Stackdriver를 읽으면서 일부 내용을 요약해 봤습니다.

내용을 읽으면서 한번 요약을 해보고

이후에는 제가 생각하는 SRE의 R&R에 대해서

이야기 해볼까 합니다.

Agile이 동작하는 구간은 Business to Development 의 구간

DevOps는 Development to Operations 구간에서 동작

DevOps = Practices, Guidelines, Culture

Site Reliability Engineering = Practices, Beliefs for Practices, Job role

SRE가 Operation을 대하는 자세는

- 자동화에 큰 관심과 노력을 기울여야 하고

- sysadmin 들이 보통 해오던 일들과 도구를 통해 같은 역할을 수행

- 신뢰성 있는, 운영하기 좋은 서비스 아키텍쳐를 from the scratch 로 디자인

SRE = 시스템 엔지니어링과 소프트웨어 개발의 교차로

SRE가 신경써야 하는 Practices들.

오너십의 분산, 에러 예산 내에서의 에러 수용 -> 실패 비용 줄이기, 자동화, 측정

인터렉션은 어떻게 정의해야 하는가?

분산되어 있는 서비스 전반에 걸쳐 요청과 응답이 문제 없는가?

결국 이런것, 즉 정상 여부를 판별할 수 있는 기준이 필요하고

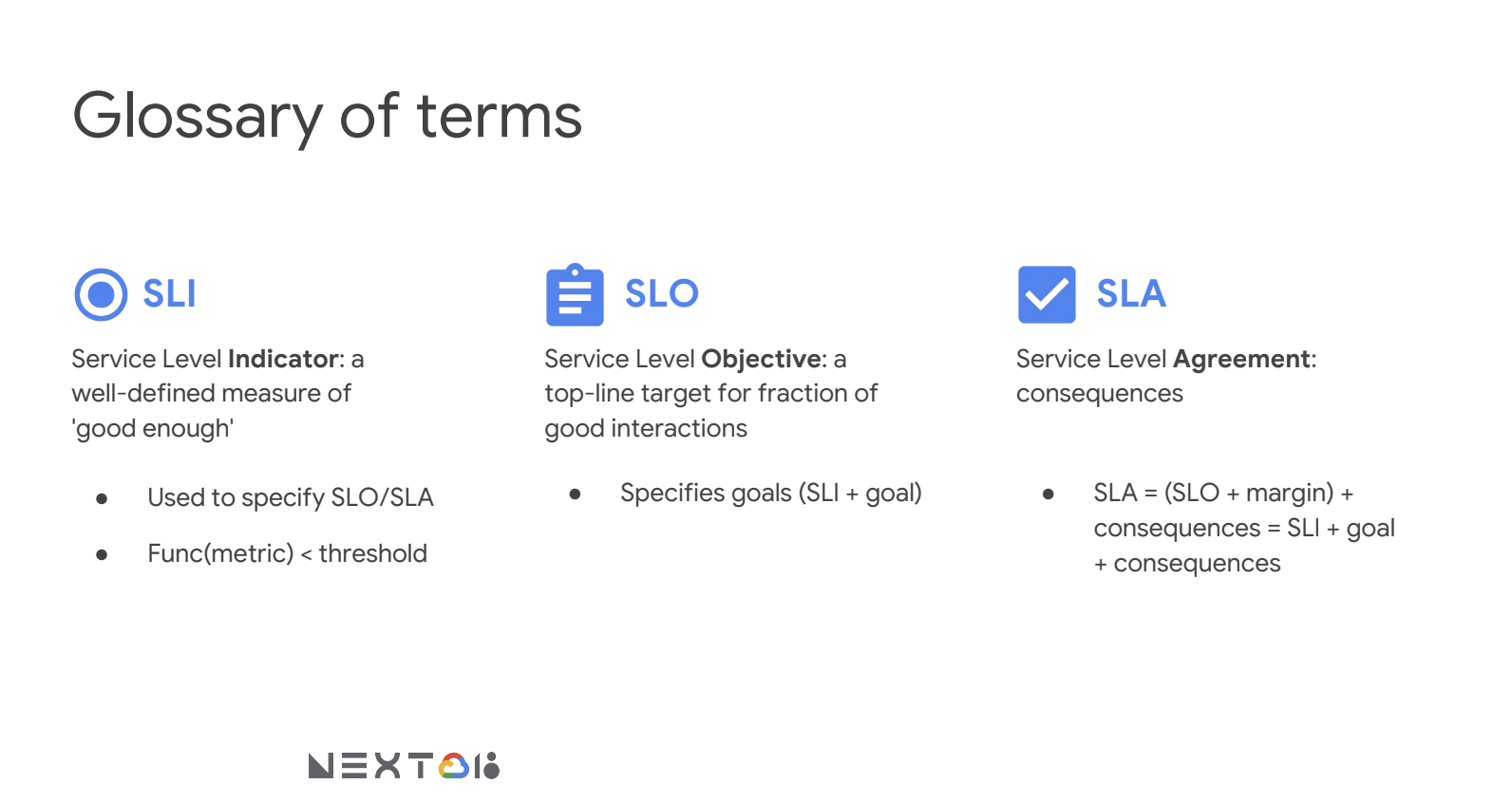

SLI (Service Level Indicator) = 좋은 상태인지 구분할 수 있는 측정치

SLO (Service Level Objective) = SLI가 도달해야 하는 최상단 목표 수치

SLA (Service Level Agreement) = SLO 추구의 결과

의 3종 셋트를 정의할 수 있어야 한다.

(To be continued...)